Ecommerce SEO Case Study

Wie wir den Traffic eines Onlineshops um 755%

gesteigert haben!

Organischer Webtraffic über Google & Co. bietet hohe Umsatzpotenziale für Online Shops. In diesem Ecommerce Case erklären wir Dir unsere SEO-Strategie und die OnPage und OffPage Maßnahmen, die zum Erfolg geführt haben.

Wir zeigen Dir wie man durch effektive SEO-Maßnahmen Top-Rankings erzielt und mehr Besucher gewinnt. Step by step – transparent und nachvollziehbar.

Inhaltsverzeichnis

Die wichtigsten Infos im Überblick

Das Beste kommt zum … Anfang. Zumindest ein Teil davon, für alle Ungeduldigen.

Das haben wir im Kurzüberblick erreicht:

Ergebnisse:

- Es wurden TOP 10, TOP 3 und TOP 1 Platzierungen zu wichtigen Keywords in den organischen Suchergebnissen bei Google erreicht, wie z. B. „Feuerlöscher“, „Feuerlöscher kaufen“, „Co2-Feuerlöscher“ und „Schaum-Feuerlöscher“.

- Laut Google Search Console sind die monatlichen Klicks über die organische Suche von 588 Klicks (November 2017) auf insgesamt 5.030 Klicks (Januar 2020) gestiegen. Das ist ein Traffic-Anstieg von insgesamt 755,44 %.

- Eine Umsatzsteigerung von 75%.

- Die Sichtbarkeit ist von 0,0021 auf 0,2552 SI-Punkte laut Sistrix gestiegen (Januar 2020).

Aufgaben und Ziele

Der Shop sollte wieder mehr Traffic, bessere Rankings und mehr Conversion über die organische Suche von Google bekommen.

Unsere Aufgabe war dabei zu analysieren, warum es zu dem besagten Absturz kam und welche Maßnahmen getroffen werden müssen, damit der Shop wieder an Traffic und Rankings gewinnt.

Maßnahmen zum Erfolg – Eine Übersicht

Damit das vorgegebene Ziel erreicht werden konnte, mussten zunächst die folgenden Schritte durchgegangen werden:

IST-Zustand

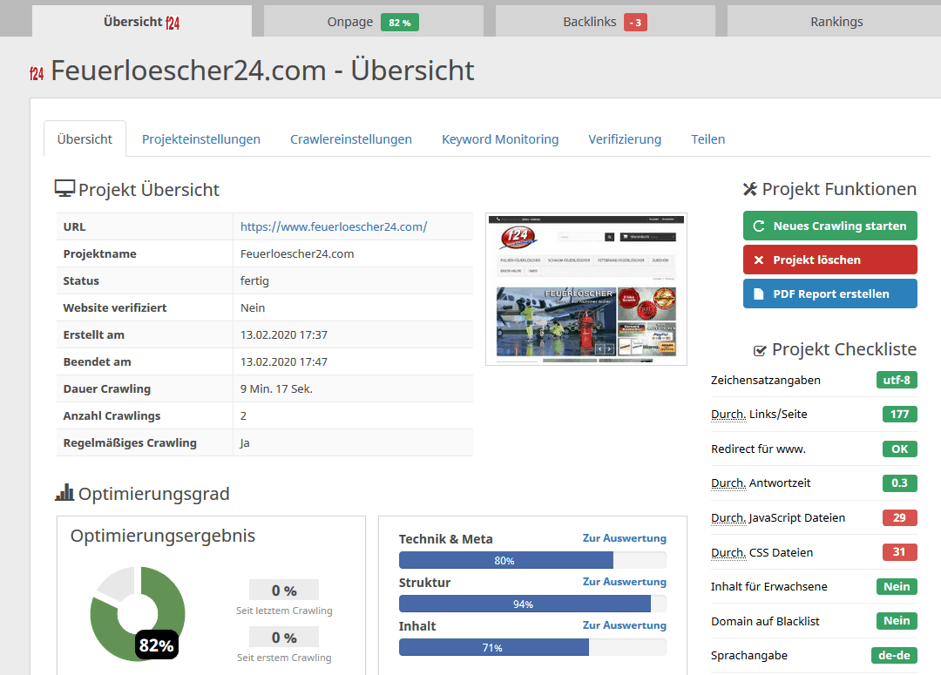

Neben der bereits erwähnten Sichtbarkeit musste der Status der Website in einem SEO Audit erfasst werden. Welche Fehler gibt es auf der Website, die zu Problemen bei der Indexierung durch Google führen können und welche Optimierungspotenziale gibt es, durch die bessere Rankings erzielt werden können?

Auch wurde erfasst, welche URLs bereits Traffic erhielten und welche zum damaligen Zeitpunkt nicht in der Suche erschienen – dafür ist eine Analyse mit Google Analytics und Search Console erforderlich.

Die Optimierungspotenziale auf der Website selbst haben wir neben der Search Console mit den Tools Screaming Frog und Seobility durchgeführt. Mit diesen drei Tools lassen sich besonders kleine bis mittelgroße Websites und Shops effektiv analysieren.

Natürlich sind die Tools nur so gut, wie der Nutzer die Meldungen deuten kann. Nur mit Erfahrung im Bereich SEO können solche Tools richtig verstanden werden und entsprechend erfolgreiche Maßnahmen abgeleitet werden.

Die Analyse des Linkprofils haben wir mit dem Tool Majestic.com und ahrefs durchgeführt. Diese SEO-Tools erfassen zuverlässig möglichst viele Links der Domain und ein Linkaudit lässt sich mit den Werten der Tools TrustFlow und CitationFlow ebenfalls zuverlässig analysieren.

Das Monitoring wurde mit Tools wie der Search Console, Sistrix und dem Ranking-Tracker Serpwatcher aufgesetzt.

Strategie

Auf Basis des Audit ist es möglich, eine SEO-Strategie zu entwickeln. Mit welchen Maßnahmen lassen sich die gewünschten Ziele erreichen? Was muss getan werden, um den maximalen Erfolg zu erzielen?

Genau das wird in der SEO-Strategie festgehalten. Ein Maßnahmenkatalog hilft dabei ebenso wie ein Projektplan, damit keine Aufgabe übergangen wird. Besonders wichtig ist es bei SEO, die Prioritäten richtig zu setzen – optimiert man hier nicht als erstes die wichtigsten Stellhebel, kann es wirklich sehr lange dauern, bis Ergebnisse zu sehen sind.

Umsetzung

Die Umsetzung der Strategie erfolgt in vier großen Aufgabengebieten. Zunächst einmal wurde eine Keyword-Recherche durchgeführt, um alle relevanten Suchbegriffe, die potenzielle Kunden über die Google-Suche eingeben, zu finden und Inhalte zu entwickeln.

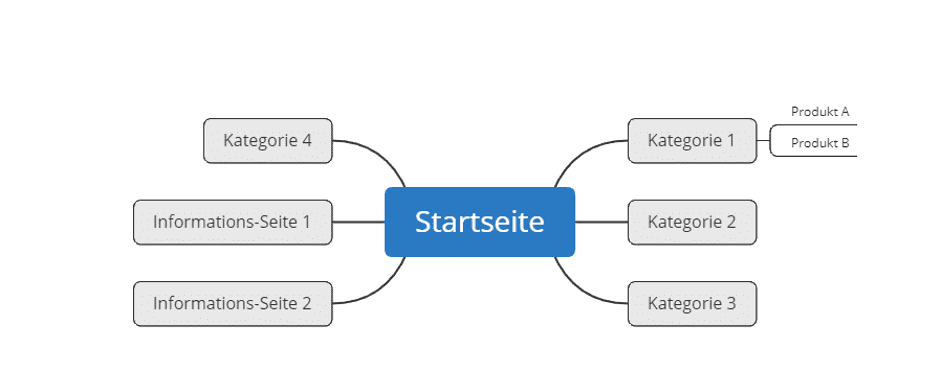

Um die Übersicht zu behalten, wird immer eine Mindmap mit allen wichtigen URLs erstellt, damit alle Beteiligten wissen, welche URLs auf welches Keyword optimiert werden sollen.

Bei der OnPage-Optimierung geht es darum, die Website bestmöglich zu optimieren, damit Google sie versteht und einwandfrei indexieren kann. Dabei wird natürlich nicht nur Google berücksichtigt, sondern auch und vor allem der User. Welche Informationen (User-Intent) sucht er und wie kann ich ihm diese auf der Website bestmöglich präsentieren? Denn Google belohnt User-zentrierte Websites besonders.

Streng genommen kann man die Inhalte (Content) auch zur OnPage-Optimierung zählen. Da bei diesem Shop jedoch besonders wenig Content vorhanden war, war dieser Punkt eine separate Leistung, denn so gut wie jede Kategorie benötigte zusätzlichen Content, der auf die Besucher und Keywords optimiert werden musste.

Bei der OffPage-Optimierung geht es darum, die vorhandenen Backlinks zu analysieren. Gibt es hier schädliche, negative Backlinks, die Rankings verhindern? Oder gibt es zu wenige gute Backlinks? Und wenn ja, wie können neue, premium Backlinks aufgebaut werden?

Monitoring

Das Monitoring oder auch die Erfolgs-Kontrolle ist ein elementarer Schlüssel für jede Optimierung.

- Werden die Ziele durch die vorgenommenen Maßnahmen erreicht?

- Muss die SEO-Strategie nachjustiert werden?

Genau das lässt sich durch Monitoring herausfinden.

SEO Audit: Was lief schief auf der Website?

Beim Audit kamen einige Optimierungspotenziale zum Vorschein, die erklärten, warum die Website so schlecht performt hatte und 2013 so plötzlich abgestürzt ist. Aber der Reihe nach:

Die Informationsarchitektur der Website war zu Beginn sehr unstrukturiert. So gab es mehrfache URLs zum gleichen Produkt, Kategorien ähnelten sich zu sehr, Texte wiederholten sich auf verschiedenen URLs (Duplicate Content).

Dazu kam, dass Title Tags und Meta Descriptions bis dahin nicht ordentlich optimiert waren. Eine Vielzahl der URLs hatte keine Meta-Angaben, weshalb Google sich diese dann selbst automatisch in den SERPs zusammenstellte. Diese automatisch erstellten Angaben sind dann nicht optimiert und meistens weit weniger schön zu lesen, als wenn man diesen Schritt selbst übernimmt.

Außerdem gab es nur ganz wenige URLs mit hiflreichen Inhalten, wie z. B. einen Rechner für erforderliche Löschmitteleinheiten (feuerloescher24.com/content/9-Loeschmitteleinheiten).

Die URLs mit den größten Optimierungspotenzialen, wie z. B. die Kategorien, waren so gut wie gar nicht mit Content befüllt. Für eine Volltext-Suchmaschine wie Google sind Inhalte aber enorm wichtig.

So gab es eine Vielzahl an Optimierungspotenzialen:

- Auf den Kategorie- und Produktseiten waren zu wenige oder gar keine Inhalte vorhanden, die einen Mehrwert gebracht hätten.

- Schlechter Aufbau der Informations- und Seitenarchitektur. Wichtige Seiten waren viel zu tief in der Website versteckt.

- 102 Seiten hatten Duplicate Content Probleme.

- 15 Seiten hatten einen 404 Status Code (Broken Links). Diese Fehlerseiten erschweren das Crawling für den Google-Bot (Webcrawler) ebenfalls.

- Es wurden 23 interne Weiterleitungen gefunden. Dadurch entstehen Weiterleitungsketten, die für das Crawling ebenfalls schlecht sein können.

- 53 Seiten standen aufgrund der bisherigen Keyword-Optimierung in Konkurrenz zueinander (Keyword-Kannibalisierung).

- Die Ladezeiten waren überdurchschnittlich hoch.

- Seiten ohne Suchintention (wie z. B. das Impressum) wurden nicht auf noindex,follow gesetzt.

- Mehr als 50 Seiten hatten keinen individuellen Title Tag und 36 Seiten hatten keine individuelle Meta Description.

- Überschriften-Struktur: Es gab mehrere H1-Überschriften pro URL und die H-Überschriften wurden insgesamt nicht in stringenter Reihenfolge platziert. So folgte z. B. eine H4- auf eine H2-Überschrift usw.

- Bilder hatten keine ALT-Tags.

- Besonders im Fließtext gab es keine oder nur wenige interne Links auf die wichtigen Kategorieseiten.

Diese und noch viele weitere Fehler auf der Website verhinderten gute Rankings für den Shop.

Und das Linkprofil?

Doch wie sah das Linkprofil aus und warum verlor die Domain Ende 2013 so stark an Sichtbarkeit:

Durch das Google Pinguin 2.1 Update büßte der Shop stark an Sichtbarkeit ein. Dank der Analyse des Linkprofils wurde schnell klar: Hier wurde eine Vielzahl an schwachen Links aufgebaut, die zum entweder nicht themenrelevant oder reiner Spam waren.

- Aufgrund der bisherigen schlechten Link-Qualität hatte der Shop so stark an Sichtbarkeit verloren.

Zudem gab es keine starken Backlinks im Linkprofil, die Google hätten zeigen können, dass der Shop es verdient hat, in den Rankings weiter nach vorne zu kommen.

Strategieentwicklung

Aus dem Audit ging hervor, dass als erstes die Domain von den schlechten Links befreit werden musste.

Wenn Google der Domain kein Vertrauen schenkt, sind alle weiteren Maßnahmen sinnlos. Die Seite brauchte also zuerst ein sauberes Linkprofil.

Danach sollte die Keyword-Recherche folgen, um möglichst viele URLs auf ein oder mehrere Keywords optimieren zu können. Ohne Keyword-Recherche wäre die Optimierung einem Blindflug gleichgekommen, mit der Recherche wussten wir, auf welche Begriffe optimiert werden muss.

Danach sollten sämtliche OnPage-Maßnahmen auf der Website und die Content-Erstellung für alle wichtigen URLs (Kategorien, Produkte usw.) erfolgen. Zum Schluss sollte der Aufbau von neuen, hochwertigen Backlinks stehen.

Zusammenfassung der SEO-Strategie

- Erholung der Domain von der Abstrafung durch entfernen/entwerten aller schädlichen Links

- Keyword-Recherche zur Identifizierung weiterer Optimierungsmöglichkeiten

- Sämtliche OnPage-Fehler auf der Website beheben und insbesondere eine sinnvolle Informationsarchitektur aufbauen

- Relevante Informationen/Texte einbauen, um einen Mehrwert auf der Website zu haben – besonders auf den Kategorieseiten

- Neue starke Backlinks aufbauen, um die Website weiter nach vorne zu pushen

- Monitoring aufsetzen, um eine Erfolgskontrolle über alle Maßnahmen zu haben

Bei der SEO-Strategie ist es neben dem Maßnahmenplan ebenfalls wichtig, sich Prioritäten zu setzen, da aufgrund von begrenzten Ressourcen nicht alle Aufgaben gleichzeitig angegangen werden können.

Umsetzung der Strategie

Bei der Umsetzung ist es wichtig, sich strikt an die Maßnahmen aus der Strategie zu halten. Nur so kann die Website Schritt für Schritt richtig optimiert werden und möglichst schnell (für SEO-Verhältnisse) Erfolge erzielen.

Schädliche Links entfernen

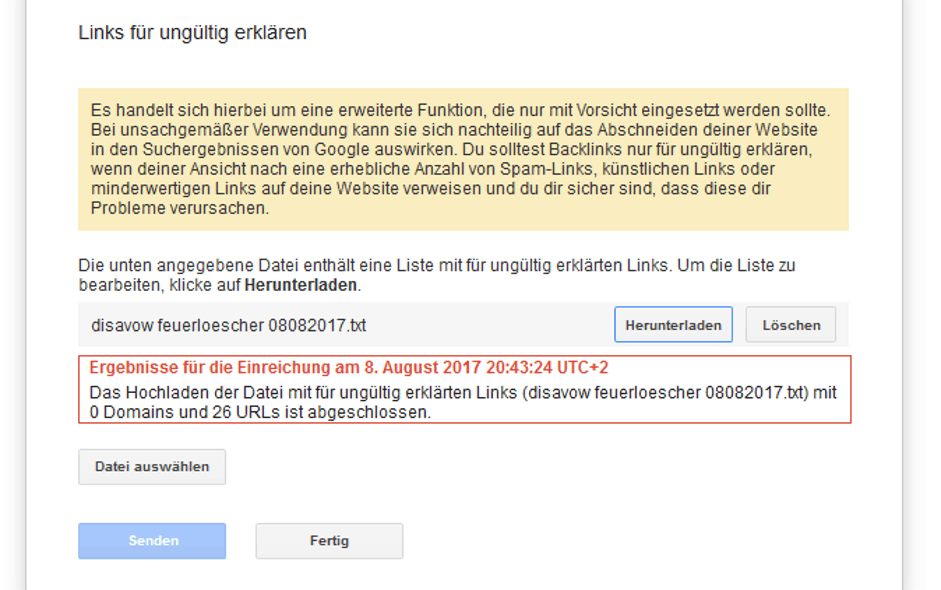

Der erste wichtige Schritt war es, raus aus der Abstrafung durch das 2.1 Pinguin Update von damals zu kommen. Dafür wurden die schlechten Links aus dem Linkprofil erfasst und entweder durch Anschreiben der Seitenbetreiber von diesen entfernt oder, wenn sich der Webmaster nicht gemeldet hatte, manuell mittels Google Disavow Tool entwertet.

In der Liste befinden sich alle URLs, die von uns als schädlich eingestuft wurden. Die entsprechenden Seiten waren unter anderem:

- nicht themenrelevant

- von Linkschleudern, also Seiten, die einzig und allein zur Linkmanipulation dienten,

- von sonstigen negativen Eigenschaften belastet, wie z. B. fremden Sprachen oder Links von Websites mit Erwachsenen-Inhalten.

Tipp: Statt einzelner URLs, kann man auch ganze Domains mit dem Befehl domain: „HierStehtEineDomain.de“ entwerten.

Wichtig: Bei der Entfernung oder Entwertung von Backlinks ist immer größte Vorsicht geboten! Werden ausversehen gute, starke Backlinks entwertet, kann das zu Ranking-Einbrüchen führen.

Keyword-Recherche

Die Keyword-Recherche fängt immer beim Kunden selbst an. Der Kunde erklärt uns sein Business und zählt wichtige Begriffe aus seiner Branche und für seine Kunden auf. Bei der Recherche nach passenden Suchbegriffen, zu denen wir den Shop optimieren können, ist das der erste wichtige Schritt.

Mit diesem Basic-Set von Begriffen können wir dann mit Tools und Recherchearbeit ein Master-Keyword-Set erstellen. In dieser Datei befinden sich dann alle Suchbegriffe, auf die der Shop optimiert werden soll.

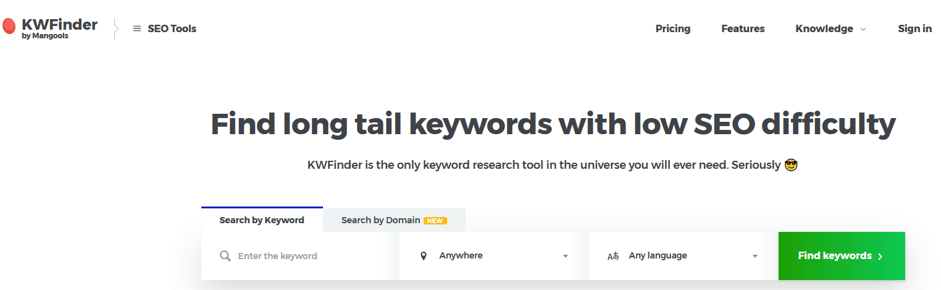

Bei diesem Shop haben wir u. a. Tools wie kwfinder.com, Sistrix.com und natürlich die klassische Google-Suche eingesetzt.

kwfinder kurz erklärt

Mit diesem Tool lassen sich besonders viele Keyword-Ideen generieren. Gibt man hier ein Keyword, z. B. „Feuerlöscher“, ein, erscheinen weitere Keyword-Ideen in Kombination mit dem Begriff in der Eingabe (siehe Bild).

Der kwfinder ist eines der Haupttools bei der Recherche. Hier sammeln wir alle Ideen, überprüfen das monatliche Suchvolumen und vieles mehr. Einziges Manko bei diesem Tool: Die Konkurrenzeinschätzung ist für kleine bis mittlere Shops leider nicht realistisch und kann daher ignoriert werden.

SISTRIX kurz erklärt

Mit Sistrix lassen sich die Rankings der eigenen Website, aber auch der Mitbewerber analysieren. Hier kann man schnell sehen, wer auf welche Keywords optimiert hat. Sistrix bietet ebenfalls die Möglichkeit, Keyword-Ideen zu einem Suchbegriff anzeigen zu lassen (siehe Bild).

Sistrix und der KWFinder sind kostenpflichtige Tools, die bei jeder Recherche unabdingbar sind. Das nächste Tool, Google selbst, ist natürlich umsonst.

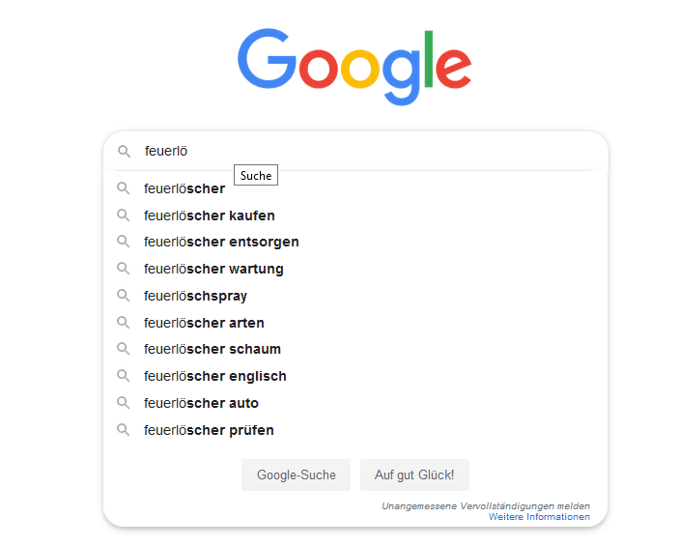

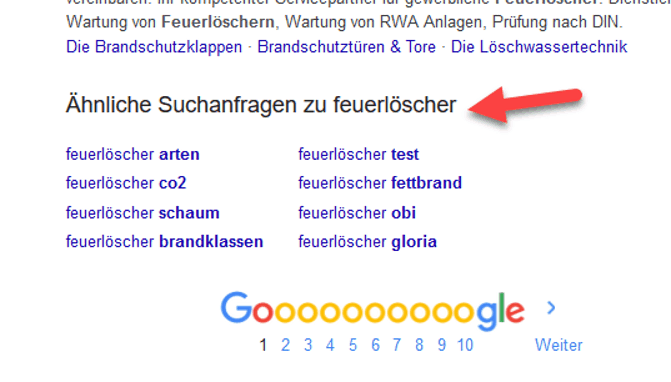

Google als Keyword-Tool kurz erklärt

Über die klassische Google-Suche lassen sich ganz einfach weitere Keyword-Ideen sammeln. Durch die Autofill-Funktion werden bereits einige Suchvorschläge angezeigt

Das Keyword-Set (Auszug)

Dank der Zusammenarbeit mit dem Kunden (hier kommen die ersten Keyword-Ideen) und der Recherche nach weiteren Keyword-Möglichkeiten konnten wir eine ordentliche Keyword-Master-Datei erstellen. Hier ein Auszug daraus:

Sobald die Keyword-Liste steht, beginnen wir mit den nächsten Schritten weiter in Richtung OnPage-Optimierung.

OnPage-Optimierung

Kommen wir zur aktiven Umsetzung der OnPage-Optimierung. Hier werden nun alle Punkte umgesetzt, die zur Verbesserung der Rankings führen sollen.

Title Tags

Zunächst setzten wir die Optimierung der Title Tags durch. Das ist ein besonders großer Stellhebel, der schnell umgesetzt werden kann. Das Problem war, dass zuvor über 20 URLs auf das Keyword „Feuerlöscher“ optimiert waren. Dank der Keyword-Recherche konnten wir jeder Kategorie ein eigenständiges Keyword im Title Tag eintragen. Zudem erhielt jede URL (die ranken sollte) einen individuellen Title Tag und eine eigene Meta Description. Hier ein Beispiel, wie wir die Startseite optimiert haben:

Große Auswahl und günstige Preise als USP. Vorsicht: Günstige Preise allein sind meist kein wirklicher USP, daher der Zusatz „große Auswahl“.

Der Title Tag wird abgeschnitten, da er zu lang ist, was jedoch nicht schlimm ist, da in der Google-Suche alle wichtigen Informationen zu finden sind.

In der Meta Description wurden neben Sonderzeichen (✓) weitere Vorteile zum Shop, wie z. B. „frachtfrei bestellen“, aufgezählt, um zum Klicken zu animieren. Genau diesem Prozess haben wir alle wichtigen Seiten unterzogen, die Rankings haben sollen.

Beim Title Tag lautet die Faustformel: immer das Hauptkeyword der jeweiligen URL an den Anfang setzen (in Kombination mit dem Wort „kaufen“) und falls möglich einen USP nennen. Wenn nicht genug Platz im Title Tag war, wurde der USP nicht mitgenommen.

Bei der Meta Description ist dies ähnlich: Keyword nennen, Sonderzeichen verwenden und USPs aufzählen, die zum Klicken animieren sollen.

Broken Links/404 Fehler

15 URLs, die im Shop verlinkt wurden, hatten einen 404 Status Code, sprich diese URLs waren gelöscht und lieferten den Fehler „URL nicht gefunden“. So etwas ist nicht nur unschön für die Nutzer, sondern auch schlecht für die Indexierung und das Crawling durch den Google-Bot. Durch Entfernung der Links bzw. Setzen der richtigen Links, wurden diese Fehler behoben.

Interne 301-Weiterleitungen

Durch interne Weiterleitung kann unter Umständen zusätzliches Crawling Budget aufgebraucht werden. Das ist nicht optimal bei der Indexierung, denn warum sollte man interne Weiterleitungen überhaupt haben? Daher haben wir alle Weiterleitungen behoben und entsprechend direkt auf die richtigen URLs gesetzt – ohne eine Weiterleitung.

Schlechte Informations- und Seitenarchitektur, Duplicate-Content-Probleme und Keyword-Kannibalisierung

Diese Punkte stellten einen besonders großen Hebel bei der Optimierung dar. Duplicate Content und Keyword-Kannibalisierung sind keine Fehler, die zu einer Abstrafung führen. Bei der Indexierung können sie aber erhebliche Probleme verursachen. Wenn mehrere URLs auf das gleiche Keyword optimiert sind, weiß der Google-Crawler nicht, welche URL zu welchem Keyword ranken soll.

Daher haben wir die doppelten Inhalte entfernt und immer jede URL, die ranken sollte, auf ein bestimmtes Keyword optimiert. So konnten wir Google zeigen, welche URL zu welchen Keywords gefunden werden sollte.

Konnten wir eine Seite nicht löschen, haben wir diese auf noindex,follow gesetzt. Insgesamt konnten wir 102 Seiten vom Duplicate-Content-Problem befreien und auf 53 Seiten, die in Konkurrenz zueinander standen, die bisherige Keyword-Optimierung ändern und so die Keyword-Kannibalisierung auflösen.

Die schlechte Informationsarchitektur sorgte dafür, dass Rankings verhindert wurden.

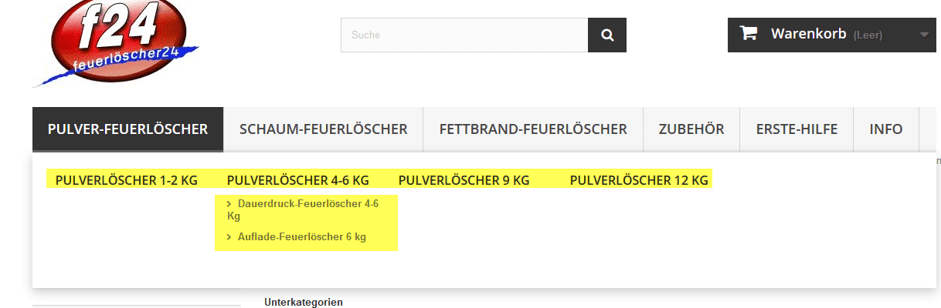

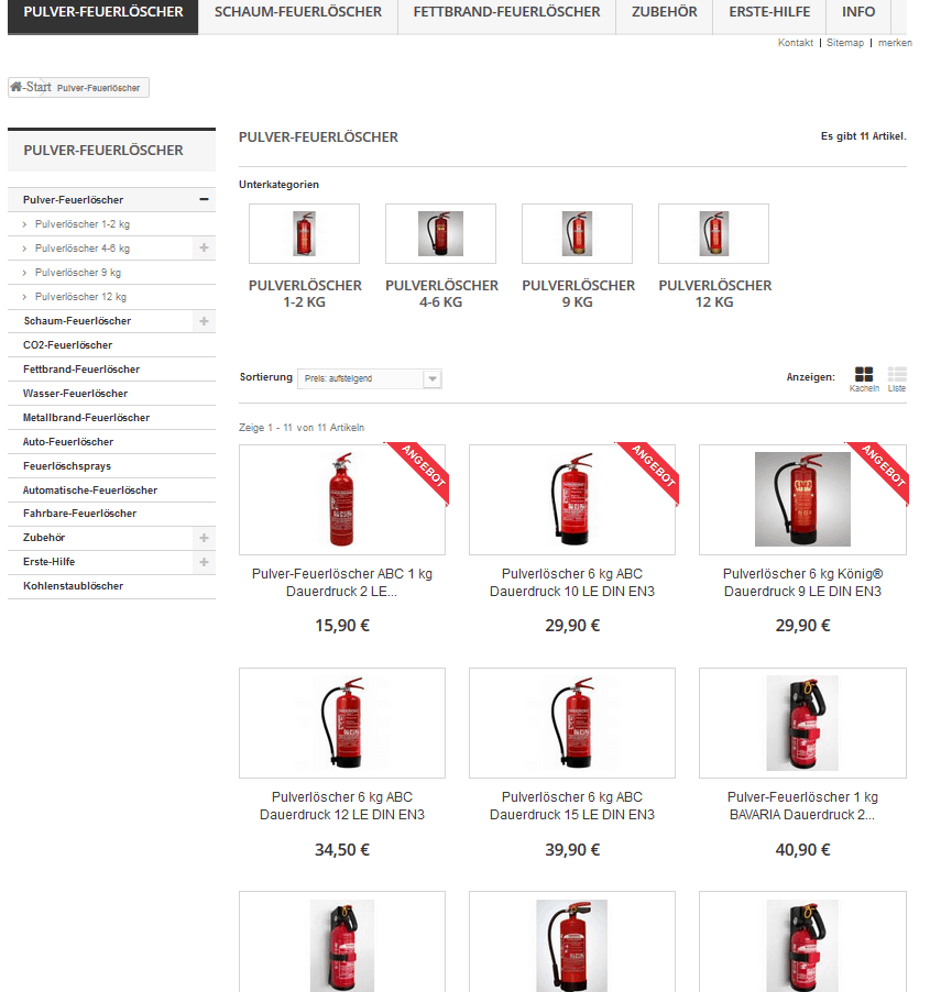

Beispiel für die damals unpassende Informations- und Seitenarchitektur:

Die Oberkategorie „Pulver-Feuerlöscher“ besteht aus den Filterseiten „Pulverfeuerlöscher 1-2 KG“, „4-6 KG“, „9 KG“ und „12 KG“.

Diese Filterseiten wurden von Google immer wieder zum Keyword „Pulver-Feuerlöscher“, der Oberkategorie, in den SERPs aufgerufen. So sprangen die Rankings hin und her – mal war eine Unterseite in den TOP 100 und dann war wieder die Oberkategorie zu finden. Google hatte also große Problem hier zurechtzukommen.

Da wir die Filterseiten nicht löschen wollten (der User will diese Aufteilung haben, da es mengen- und preistechnisch einen erheblichen Unterschied macht, ob man einen 2 kg oder 12 kg schweren Löscher kauft), mussten wir diese Filterseiten auf noindex,follow setzen.

Die Ergebnisse waren schnell zu sehen: Die Oberkategorie fing endlich an, für das Hauptkeyword „Pulver-Feuerlöscher“ zu ranken.

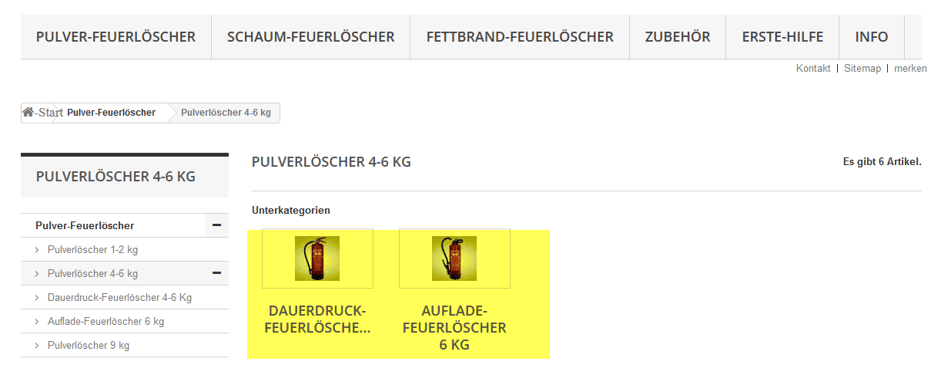

Allerdings gab es noch ein weiteres Problem mit den Kategorien: Bis man die Produkte zu sehen bekam, musste man sich zunächst einmal durch die Unterkategorien durchklicken.

Der Ablauf an einem Beispiel:

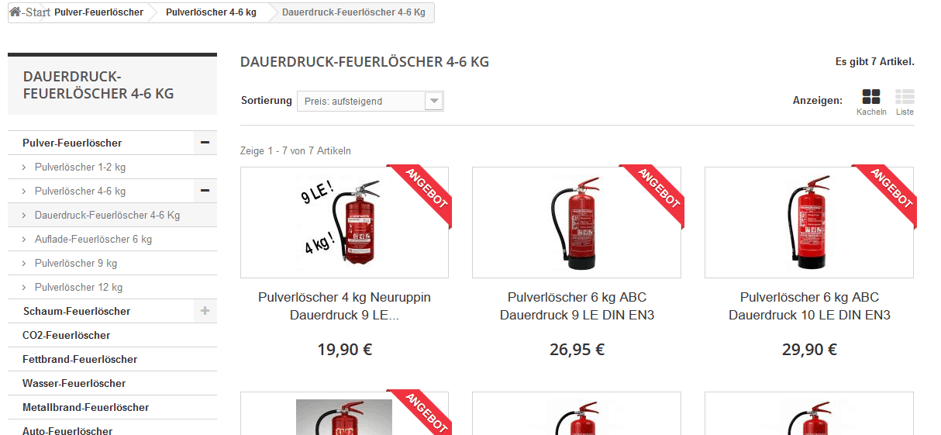

Von der Oberkategorie benötigte es 3 Klicks bis zu den Produkten – das ist zu lang für den User und die Indexierung durch Google. Produkte sollten bereits in der Oberkategorie eingebaut sein.

Statt Produkten waren in der Oberkategorie erstmal nur ein sehr kurzer Text (1-2 Sätze) und die dazugehörigen Unterkategorien aufgelistet. Die Optimierung bestand darin, dass zunächst alle Produkte in der Oberkategorie angezeigt werden.

Das war eigentlich ein einfacher Schritt, der jedoch große Wirkung gezeigt hat. Google und die Nutzer wollen natürlich Kategorieseiten haben, die die Produkte direkt anzeigen. Niemand will sich erst durchklicken müssen.

Da die Unterkategorien (Filterseiten, wie „2 L Schaumlöscher“) wie gesagt nicht gelöscht werden konnten, blieben diese auf noindex,follow, um eine Keyword-Kannibalsierung zu vermeiden.

Hinweis zu Kategorie-Optimierungen: sauberer wäre es, über einen Filter, der bei Shops normalerweise üblich ist, verschiedene Produktarten in einer Kategorie zu sortieren – diese Optimierung ist für die Zukunft geplant.

Thin Content / Fehlende Texte auf den Kategorieseiten

Auf den Kategorieseiten gab es so gut wie keinen Content. Es gab nur eine Überschrift und 2-3 Links zu den nächsten Unterkategorien. Solche Seiten können kaum gut ranken, weil sie keinen Mehrwert für den Nutzer haben und damit auch für Google nicht brauchbar sind.

Neben dem bereits erwähnten Einbau von Produkten erstellten wir Texte für die jeweiligen Oberkategorien, die ranken sollten, z. B. für die Kategorie „Pulverlöscher“.

Die Inhalte der Kategorietexte leiteten wir zum einen von den Keywords ab und zum anderen von den Fragen der Nutzer. Besonders oft steht z. B. die Frage im Raum, für welche Brandklasse der angebotene Feuerlöscher zulässig ist und ab wann Feuerlöscher verpflichtend sind.

Content auf der Startseite

Auch auf der Startseite gab es keinen Text, sondern nur Links und Bilder zu den Kategorien und Produkten. Da die Startseite zum Keyword „Feuerlöscher“ ranken sollte, mussten wir hier ebenfalls einen Fließtext einbauen. Das Keyword „Feuerlöscher“ ist ein sehr generischer Begriff und der Search Intent ist hier unterschiedlich.

Manche User scheinen sich nur über die verschiedenen Feuerlöscherarten informieren zu wollen, während andere direkt einen kaufen möchten.

Wir haben uns daher für folgende Lösung entschieden: Auf der Startseite sollten die Links und Bilder zu den Produkten bestehen bleiben, jedoch auch genügend Informationen zu finden sein, um User, die auf der Suche nach Informationen sind, zufriedenzustellen.

Daher haben wir Texte mit möglichst vielen Informationen zum Thema Feuerlöscher erstellt, inkl. Tabellen und Bildern zu den Brandklassen. Durch diesen Schritt wollten wir sowohl den transaktionalen (User will etwas kaufen) als auch den informationalen (User will Informationen haben) Intent befriedigen.

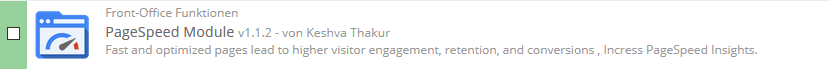

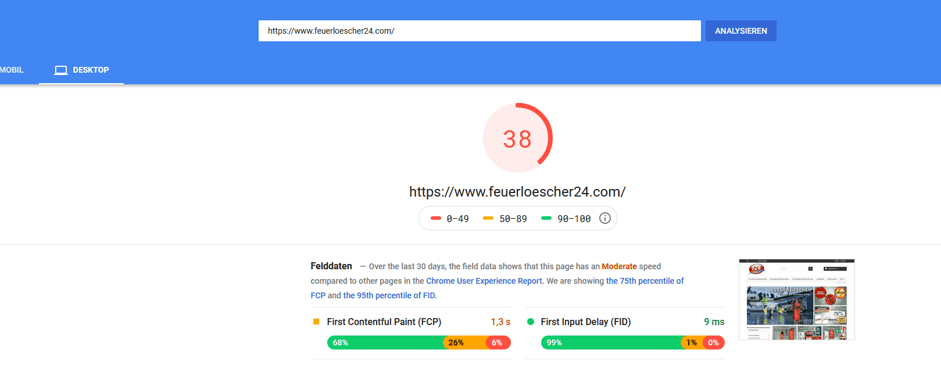

Die Ladezeiten waren überdurchschnittlich hoch

Vor der Optimierung gab es Ladezeiten von 5-7 Sekunden für die Start- und Kategorieseiten. Bis dahin wurde kein Caching eingesetzt, die Server-Antwort-Zeiten waren viel zu hoch und vieles mehr erhöhte die Ladezeit. Im Shop wurde ein Caching Plugin installiert, Bilder wurden komprimiert und so weiter.

Die Ladezeiten für die Startseite liegen seitdem bei ca. 1 Sekunde laut Pingdom, was bereits ein guter Wert ist.

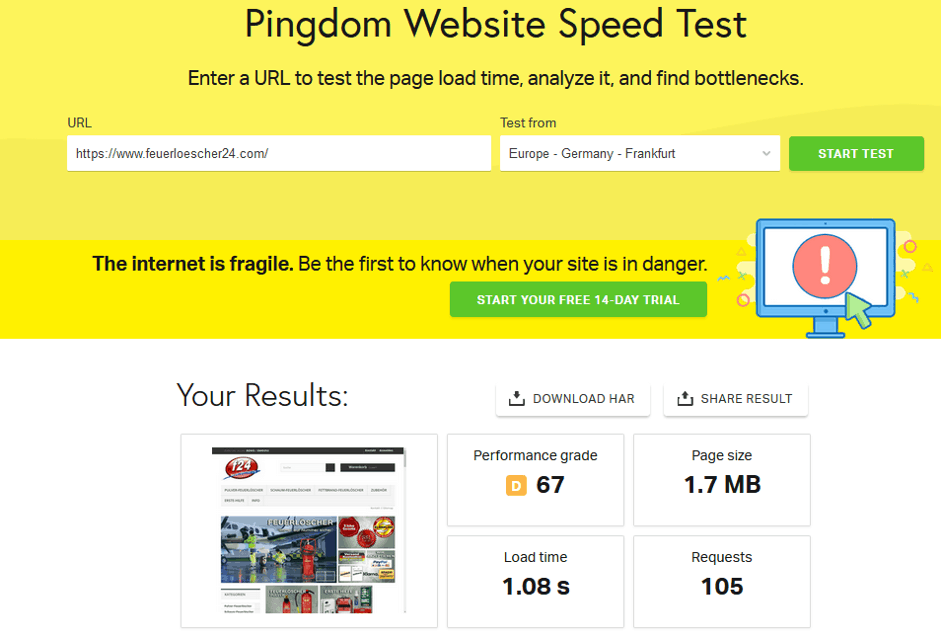

Seiten ohne Suchintention

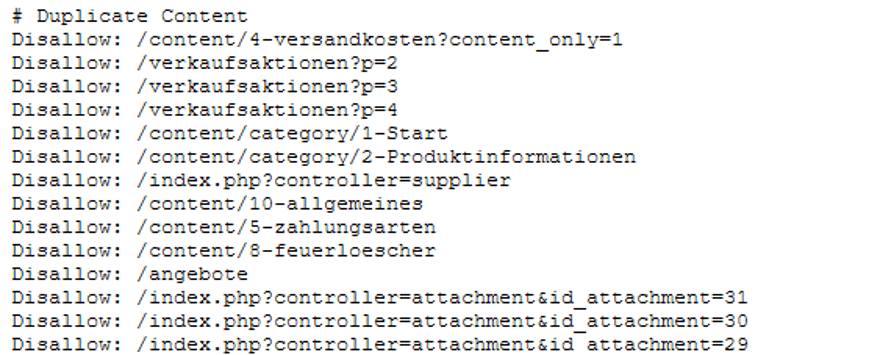

Warum sollten wir Suchmaschinenindex mit Seiten vollstopfen, die sowieso keine Relevanz haben? Daher haben wir Seiten, die zwar nicht gelöscht werden konnten, aber auch ohne Suchintention sind (Seiten wie Impressum und Datenschutz, die nichts im Suchindex verloren haben), auf noindex,follow gesetzt. Über die beiden Module „SEO Center: Bulk Edition“ und „SEO Noindex,follow“ wird die Indexierung der einzelnen Seiten gesteuert.

URLs, wie z. B. der Warenkorb, die nicht über das CMS-System auf noindex gesetzt werden konnten, wurden mittels Robots.txt für die Suchmaschinen gesperrt. Aber auch Duplicate Content musste darüber stellenweise behoben werden, da diese Seiten nicht über das CMS auf noindex gesetzt wurden konnten.

Weitere Optimierungen:

- Bilder ohne ALT-Tags

Ein Klassiker: Alle Bilder im Shop mit einem passenden ALT-Tag ausstatten. Das ist etwas Fleißarbeit, lässt aber die Bilder in der Google-Bildersuche und damit auch den Shop besser dastehen und bringt entsprechende Verbesserungen in den Rankings mit sich.

- Überschriften-Struktur

Es gab mehrfach H1-Überschriften auf den Kategorie- und Produktseiten und die H-Überschriften waren zudem nicht in stringenter Reihenfolge platziert worden. So kam zuerst eine H2, die von einer H4 Überschrift gefolgt worden ist. Diese Anpassung ist nicht der wichtigste Rankingfaktor schlechthin, aber durch eine lückenlose Aufzählung ist die Seite auch hier sauber optimiert.

- Interne Verlinkungen

Interne Links zu den wichtigsten Kategorieseiten wurden in den Fließtext gesetzt, um hier alle wichtigen Kategorien permanent verlinkt zu haben.

- Seiten ohne SSL-Verschlüsselung

Es gab stellenweise Bilder, die nicht über SSL-Verschlüsselung geladen wurden, daher kam es zu dem Effekt, dass im Browser manche URLs als „unsicher“ angezeigt wurden. Durch das richtige Verschlüsseln wurden alle Bilder schließlich über SSL geladen.

OffPage-Optimierung

Neben der bereits beschriebenen Entwertung sämtlicher schädlicher Links, haben wir gerade einmal zwei Backlinks über Kooperationen aufgebaut – that´s it. Mehr Links haben wir nicht aktiv aufgebaut.

Es ist allerdings anzumerken, dass die Seite bereits über viele Backlinks verfügt und wir hier keine hunderte von neuen Backlinks mehr aufbauen mussten, sondern der Domain durch zwei starke Links genügend Trust gegeben haben, um die Rankings zu verbessern.

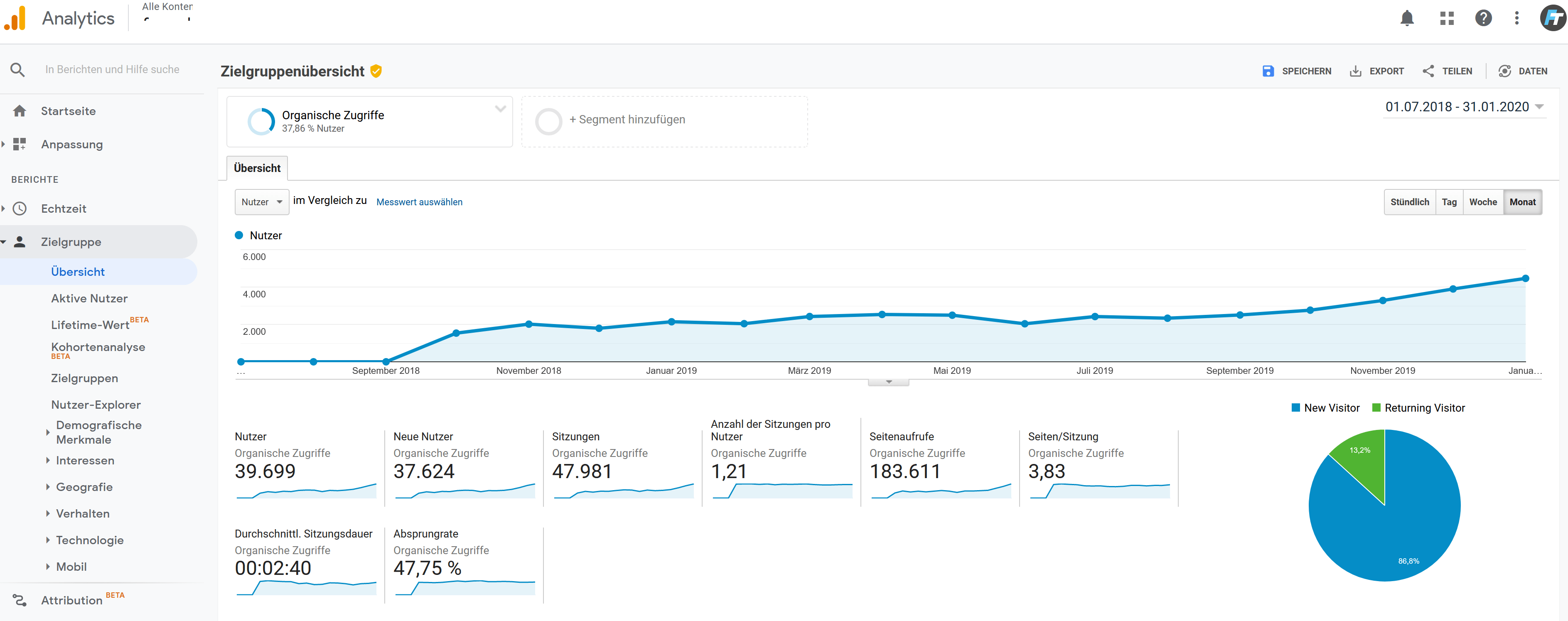

Monitoring und Erfolgskontrolle

Das Monitoring ist enorm wichtig und wurde gleich zu Beginn der SEO-Kampagne aufgesetzt und ununterbrochen fortgeführt. Denn nur mit validen Daten lassen sich die Erfolge der Umsetzungen messen und daraus die richtigen weiteren Maßnahmen ableiten. So konnten wir sehen, dass die Startseite des Shops aufgrund des langen Fließtextes anfing gut zu ranken – ein Beweis, dass diese Art von Text erfolgreich war.

Beim Monitoring setzten wir auf drei bzw. vier große Tools:

- Google Search Console

- Google Analytics

- Serpwatcher

- (Sistrix)

Über die Google Search Console und Google Analytics konnten wir die Performance jeder einzelnen URL tracken und schauen, wie sich der (organische) Traffic entwickelt. Über die Search Console sahen wir zudem die CTR-Entwicklungen, Rankings zu Keywords, wichtige Meldungen, falls die Seite schwere Indexierungsprobleme hatte, und vieles mehr.

Über den Serpwatcher legten wir das Keyword-Set des Shops an, um die tägliche Entwicklung der Keyword-Rankings im Blick zu haben. Sistrix hatten wir ebenfalls im Einsatz, um die gesamte Performance des Shops zu sehen.

Ergebnisse im Detail

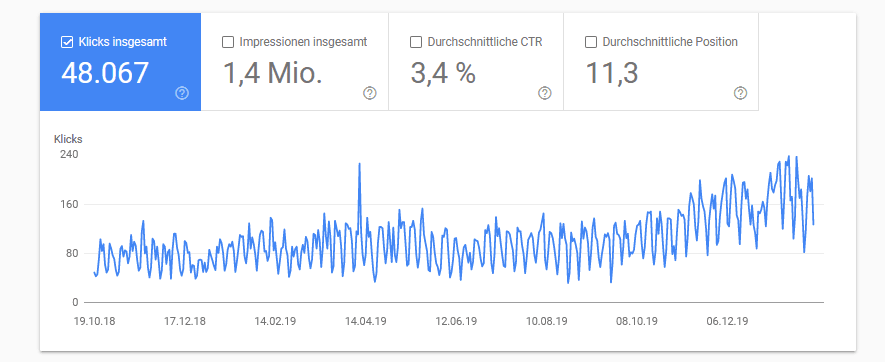

Die Optimierungen starteten August 2017 und bis jetzt (Januar 2020) konnte ein Traffic-Zuwachs von 755% gemessen werden laut Search Console.

Bestimmte Optimierungen, wie z. B. noch bessere Ladezeiten, konnten aufgrund von Problemen mit dem CMS noch nicht umgesetzt werden.

Und trotzdem hat der Shop einen enormen Traffic-Zuwachs erhalten und TOP Keyword-Rankings erzielt.

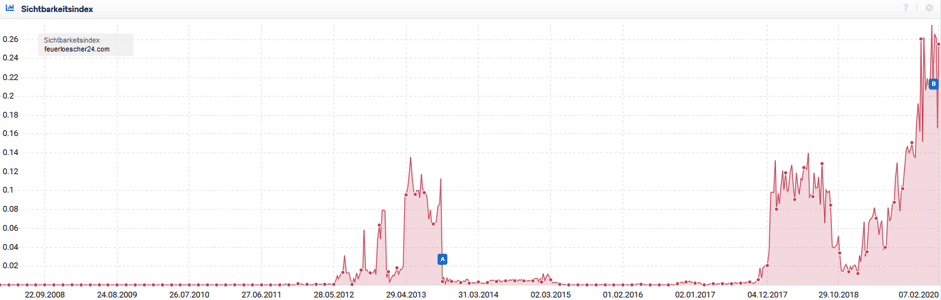

Die aktuelle Sichtbarkeit laut Sistrix (Stand 31.01.2020)

Die Sichtbarkeitskurve geht nach einem Down-Trend im Herbst/Winter 2018 wieder steil bergauf.

Der Abfall der Sichtbarkeit ist damit zu erklären, dass der Shop zum Keyword „Feuerlöscher“ für ein paar Monate nicht mehr in den TOP 10 gelistet war.

Das Besondere daran: Der Traffic über die organische Suche ist in diesem Zeitraum trotzdem gestiegen, da die Seite über Mid und Longtail Keywords viel Traffic generiert.

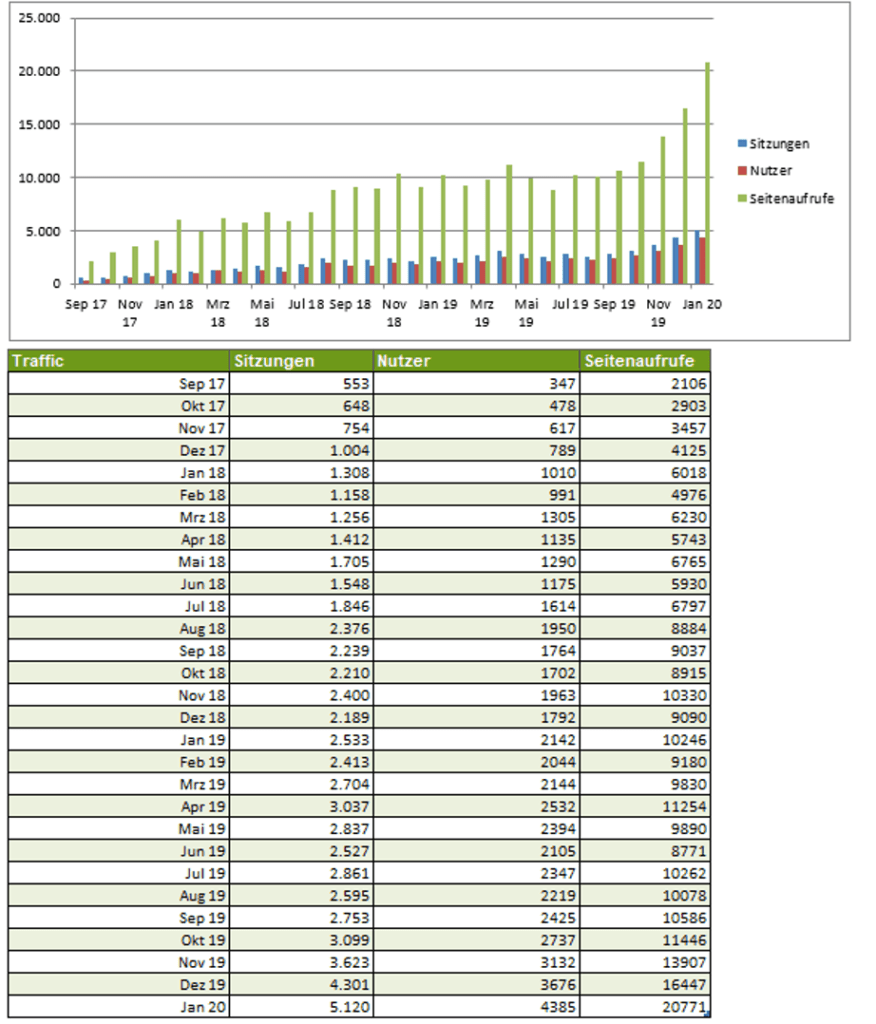

Traffic-Entwicklung (Stand 31.01.2020)

Laut Google Search Console konnten die Klickzahlen von 588 Klicks im November 2017 auf 5.030 Klicks im Januar 2020 gesteigert werden. Das ist ein organischer Traffic-Zuwachs von 755,44 %!

Auch schön zu sehen: Der Traffic ist von Monat zu Monat stetig gewachsen. Es gab kaum einen Monat, in dem der Traffic abgefallen ist. Hier ein Auszug mit allen Zahlen aus dem Kundenreport:

Ranking-Entwicklung

Die Entwicklung der Rankings haben wir mit dem Tool Serpwatcher.com getrackt:

Hier sieht man sehr gut die Entwicklung der Rankings und Sichtbarkeit laut Tool vom 01.03.2018 bis 31.01.2020 (weiter in die Vergangenheit kann man bei dem Tool leider nicht gehen).

Für die Zukunft

Für die Zukunft sind weitere Optimierungen angesetzt.

So gibt es z. B. immer noch die Unterkategorien, die bislang nur auf noindex,follow gesetzt wurden. Hier wäre eine Löschung angebracht und ein Filtersystem direkt über die jeweilige Oberkategorie besser geeignet – je weniger Klicks, desto besser für die Nutzer und damit auch für Google. Mit der aktuellen Lösung scheint Google aktuell aber keine Probleme zu haben.

Bislang wurden nur wenige strukturierten Daten hinterlegt. Auch wenn diese zwar kein Rankingfaktor sind, können die eigenen SERPs z. B. mittels FAQ Markup und Sterne-Bewertungen optisch verbessert und damit die CTR optimiert werden.

Die Ladezeiten sind noch lange nicht gut, auch wenn sie aktuell bei ca. 1,1 Sekunden liegen. Laut dem Testing Tool von Google geht hier noch einiges.

Learnings

Für gute Rankings und viel Traffic über die organische Google-Suche müssen nur die richtigen und wichtigen Stellhebel optimiert sein und mit genug Zeit kann der Google-Traffic über die kostenlose Suche fließen.

- Nur ein langer Atem führt zum Erfolg:

Der Traffic ist zwar um 755 % gestiegen, aber es hat 2 Jahre und 5 Monate (August 2017 – Januar 2020) gedauert, bis der Traffic so stark nach oben gegangen ist.

SEO muss auf lange Sicht betrachtet werden, von heut auf morgen kommen keine guten Rankings. Allein die ganzen Optimierungspunkte umzusetzen, die Analyse, der Audit usw., braucht einfach Zeit. Hinzu kommt, dass Google selbst Zeit benötigt, um alle Veränderungen zu begreifen. Wer bei SEO Zeit mitbringt, wird letzten Endes belohnt werden!

- Abkürzungen über schäbige Backlinks bringen gar nichts:

Im Gegenteil, wie man sieht, wurde der Shop für seine vielen schlechten Links abgestraft. Erst durch die Entwertung der Links konnte der Shop wieder ranken.

- Immer OnPage vor OffPage:

Direkt neue Backlinks aufzubauen, hätte keinen großen Effekt mit sich gebracht. Auf der Website gab es keinen Mehrwert für User, warum sollte Google so etwas ranken? Zuerst müssen die großen OnPage-Schnitzer behoben werden, bevor es an die OffPage-Optimierung geht.

- Keine Panik, nur weil Sistrix oder irgendeine Sichtbarkeitskurve nach unten geht:

Ein Abfall der SI-Kurve von Sistrix muss nicht bedeuten, dass man Traffic verliert oder gar abgestraft wurde. In diesem Case sieht man sehr schön, dass der kurzzeitige Verlust des guten Rankings für das Traffic-starke Keyword „Feuerlöscher“ keine Auswirkungen auf den Traffic hatte.

Ein Großteil des Traffics kommt über Longtail Keywords. Man sollte sich niemals von 1-2 Keywords abhängig machen, sondern ein großes Keywordset haben (sofern es die Nische zulässt) und darauf optimieren. (Konzentriere dich auf Mid und Longtail)

- Kleine Fehler sind nicht schlimm bzw. die Website muss nicht perfekt sein:

Auch nicht perfekte Websites können ranken – solange die wichtigsten Optimierungen umgesetzt sind.

- Content ist wichtig:

Besonders die Kategorieseiten brauchen Content. Auch war es hilfreich, die Startseite mit ausreichend Content zu befüllen. Hier ist noch eine weitere Case über die Wichtigkeit von Content.

- Seiten auf noindex zu setzen, kann helfen:

Da wir die Filterseiten aus dem Menü nicht löschen konnten/durften, mussten wir diese auf noindex,follow setzen, damit hier keine Keyword-Kannibalisierung entstand. Soweit kein Problem für Google – jede Kategorie rankt jetzt zu den richtigen Keywords.

- Seiten können auch über die Robots.txt ausgeschlossen werden:

Lassen sich Seiten nicht über das System auf noindex schalten, können diese auch über die Robots.txt geblockt werden – kein schöner Schritt, aber er funktioniert.

- Klare Ansagen an Google machen, welche URL auf welches Keyword ranken soll:

Wichtig: Soweit es geht, soll jede URL auf ein bestimmtes Keyword optimiert sein. Seiten wie das Impressum usw. kann man natürlich nicht optimieren, aber warum auch? Wichtig sind die URLs, die verkaufen sollen: Produkte und Kategorien.

- Ladezeiten sind wichtig, aber nicht DER große Rankingfaktor:

Google verzeiht hier viel, auch wenn der Pagespeed-Wert laut Google schlecht ist, auf die tatsächliche Ladezeit kommt es an. Und die ist mit 1,1 Sekunden auf jeden Fall in Ordnung.

- Damit der Shop rankt, haben wir nur wenige Backlinks gebraucht:

Backlinks sind wichtig, ja, aber nicht die Anzahl, sondern die Qualität. Hinzu kam, dass der Shop schon viele Backlinks hatte. Nach der Bereinigung der schlechten Backlinks war das Linkprofil sauber und durch das Setzen von zwei hochwertigen Links war genug Vertrauen von Google da und entsprechende Rankings wurden möglich.

Fazit

Die größte Herausforderung bei SEO ist es, Kontinuität und Geduld zu wahren.

Nicht bei jedem Projekt wird der Traffic ständig nach oben gehen. Es kann auch Monate geben, in denen es mal weniger Traffic gibt als davor – das ist ein völlig normaler Prozess. SEO braucht einfach Zeit!

Auch vergessen viele, die SEO Basics zu befolgen. Klare Regeln und ein Ablaufplan helfen dabei, SEO richtig anzugehen und Erfolge zu feiern.