Die OnPage Optimierung ist ein Teil der Suchmaschinenoptimierung und beinhaltet alle Maßnahmen der Optimierung, die auf der Website selbst durchgeführt werden. Das Gegenstück dazu ist die OffPage Optimierung, die sämtliche Maßnahmen außerhalb der Website, wie den Linkaufbau, beinhaltet.

Die OnPage Optimierung ist ein Teil der Suchmaschinenoptimierung und beinhaltet alle Maßnahmen der Optimierung, die auf der Website selbst durchgeführt werden. Das Gegenstück dazu ist die OffPage Optimierung, die sämtliche Maßnahmen außerhalb der Website, wie den Linkaufbau, beinhaltet.

Die OnPage-Optimierung ist in drei große Teile untergliedert:

- technische,

- inhaltliche und

- strukturelle Anpassungen.

Ziel der OnPage-Maßnahmen ist es, die Website so zu gestalten, dass die Suchmaschinen sie bestmöglich verstehen und sie zu relevanten Suchbegriffen von der Zielgruppe gefunden wird.

Warum die OnPage-Optimierung im SEO wichtig ist

Die OnPage-Optimierung ist ein wichtiger Bestandteil im SEO, da nur eine für die Suchmaschinen-Crawler sehr gut auslesbare Website auch entsprechend gute Positionen in den Suchergebnissen erzielen kann. OnPage-Probleme können gute Rankings verhindern, selbst wenn die Website über ein starkes Linkprofil verfügt. Daher sollten OnPage- immer vor OffPage-Maßnahmen stehen.

Wichtige Elemente bei der OnPage-Optimierung

Die Optimierung beinhaltet verschiedene Bestandteile auf einer Website, angefangen bei technischen Maßnahmen, wie der Optimierung von Ladezeiten, über die Erstellung von relevanten Texten nach dem Search Intent (Suchintention) von Keywords (Suchbegriffen) bis hin zur Anpassung der Informationsarchitektur der Website. Die OnPage-Optimierung umfasst daher ein großes Gebiet an verschiedenen Einzelmaßnahmen im SEO.

Meta Tags optimieren

Mit den Meta Tags kann den Suchmaschinen erste Informationen über die Inhalte auf einer Website mitgeteilt werden. Dabei gibt es verschiedene Meta Tags, die unterschiedliche Gewichtung bei der Optimierung haben. Zu den SEO-relevanten Meta Tags gehören unter anderem:

- Title Tag / Meta Title

- Meta Description

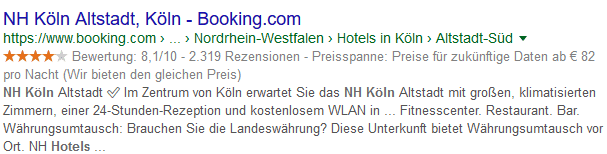

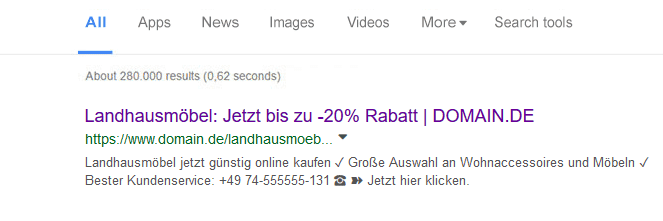

Title Tag und Meta Description

Der Title gibt den Seitentitel einer Webseite (URL) an. Die Meta Description ist die dazugehörige Beschreibung. Jede URL sollte einen einzigartigen Title und Description haben, beide zusammen können als SERP Snippet bezeichnet werden. Diese werden in den Suchergebnissen der Suchmaschinen dargestellt.

Die Länge des Titles sollte 65 Zeichen nicht überschreiten. Ist der Title zu lang, kann es sein, dass Google diesen nur verkürzt anzeigt. Allerdings wird die Länge von Google selbst nicht über die Zeichenlänge bestimmt, sondern über eine Pixelbreite. Die Meta Description sollte nicht mehr als 200 Zeichen umfassen.

Der Title und die Description sind das erste, was Suchmaschinen-Besucher von einer Website sehen. Sie sind sozusagen dein Aushängeschild in den Suchmaschinen. Daher solltest man einen Title und Description für jede URL wählen, der den Besucher zum Klicken animiert. Das AIDA-Prinzip hat sich bei der Erstellung von guten Title/Description, die besonders oft geklickt werden, bewährt.

Zum optimalen Title und Description:

- Attention: Der Title sollte die Aufmerksamkeit auf sich lenken.

- Interest: Der Title sollte das Interesse der Suchmaschinen-Besucher wecken.

- Desire: Der Wunsch, die Informationen. die sich auf der Website befinden, zu erfahren.

- Action: Der Besucher klickt in den Suchmaschinenergebnissen auf die Webseite.

Emotionale Ansprache mit dem Aufzeigen von Vorteilen stellt einen guten Title und Description dar, der oft geklickt wird. Zu vermeiden gilt es sinnlose Aneinanderreihung von Keywords im Title.

- Das Hauptkeyword, zu dem die URL gut gefunden werden soll, an die erste Stelle setzen

- Nicht zu viele Keywords, max. 2 Keywords pro Title/Description

- Viele USP (Alleinstellungsmerkmale) einbauen. Ein USP sollte immer hinter dem Keyword im Title sein, der eine konkrete Aussage trifft, z. B. “über 250 Filialen deutschlandweit”,“große Auswahl” oder “günstige Preise”

- Keine leeren Werbeversprechungen, den Besucher nicht enttäuschen

- Jede URL sollte ein einzigartiges Snippets haben

Beispiel:

Auf https://www.sistrix.de/serp-snippet-generator/ kann Title und Description getestet und perfektioniert werden.

Meta Keywords

Meta Keywords werden von Google nicht berücksichtigt. Hierfür sollte keine Aufmerksamkeit und Arbeit investiert werden.

Robots.txt

Die Robots.txt Datei ist ein Texdatei mit der man Suchmaschinen-Bots Befehle zur Website geben kann, um z. B. bestimmte Bereiche nicht auszulesen und zu indexieren. Fehler, können hier Rankings gefährden, wenn Suchmaschinen-Crawler fälschlicherweise ausgeschlossen werden.

Mit dem Befehl „disallow“ wird den Bots der Suchmaschinen bestimmte Pfade einer Website gesperrt.

Bei der OnPage-Optimierung ist es daher wichtig, die Robots.txt zu überprüfen, um KEINE wichtigen Suchmaschinen vom Indexieren der Website auszuschließen. Hier kann dies überprüft werden: https://de.ryte.com/free-tools/robots-txt/

Strukturierte Daten (schema.org)

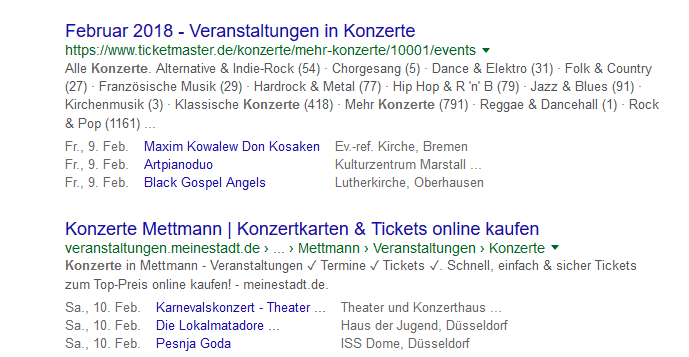

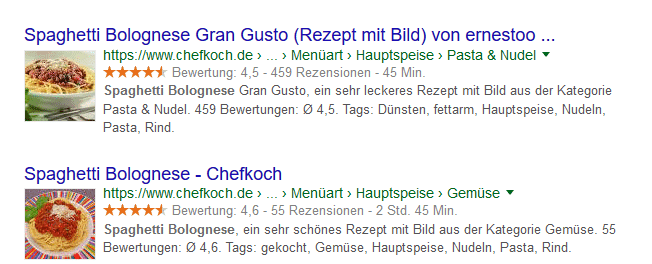

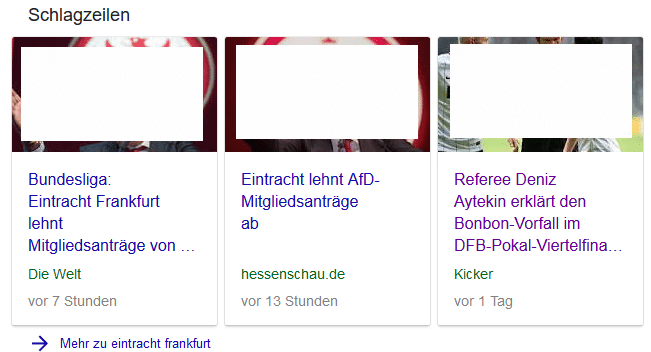

Structured Data helfen den Suchmaschinen dabei, Informationen, die sich auf einer Website befinden, besser zu verstehen. Mit strukturierten Daten hat man die Möglichkeit, zusätzliche Informationen zu übermitteln und diese in den Suchmaschinenergebnissen anzeigen zu lassen. Beispiele:

Veranstaltungen

Sterne-Bewertungen, Preisspanne

Rezepte

Nachrichten-Artikel

Es kann über verschiedene Arten strukturierte Daten implementieren werden – beispielsweise über den Google Tag Manager.

Schema.org ist ein Art Übersetzung für strukturierte Daten, mit denen man Informationen übermitteln kann. Damit Schema.org eingesetzt werden kann, wird eine Sprache benötigt, wie z. B. JSON-LD, damit diese bspw. von Google gelesen werden kann. Nicht alle Suchmaschinen können JSON-LD komplett auslesen und spielen manche Informationen nicht aus.

Auf https://validator.schema.org/ kann man überprüfen, ob die implementierten Daten richtig funktionieren. Google hat bestätigt, dass sie durch strukturierte Daten Websites besser verstehen, diese jedoch kein direkter Rankingfaktor darstellen.

XML Sitemap

Eine Sitemap kann als eine Art Inhaltverzeichnis einer Website verstanden werden. Damit können die Suchmaschinen-Crawler besser alle Seiten einer Website finden und indexieren. Über die Google-Search-Console kannst die Adresse der Sitemap eingetragen werden, um sicherzustellen, dass diese auch gefunden wird. Die meisten CMS-Systeme bieten Plugins an, damit eine Sitemap automatisch erstellt wird.

Bei WordPress können das Plugin Yoast SEO oder das Plugin Google XML Sitemaps diese Funktion übernehmen. Es ist wichtig darauf zu achten bei der Sitemap, dass dort nur Seiten sind, die auch indexierbar sind und keine Seiten aufgenommen werden, die auf noindex stehen ODER die mittels Robots.txt geblockt werden.

Besonders große Website (>10.000 URLS) sollten eine Sitemap.xml haben und diese in der Search Console eingetragen werden. Jede Suchmaschine gibt teilweise verschiedene Vorgaben bei Sitemaps. Google kann nur Sitemaps mit max. 50.000 URLs verarbeiten bzw. mit einer max. Dateigröße von 50 MB. Alles darüber sollte in mehrere Sitemaps aufgeteilt werden.

Content

Google ist eine Volltextsuchmaschine. Das bedeutet, es muss mit den Inhalten der Website der Suchmaschine zu verstehen geben, zu welchen Suchbegriffen diese relevant ist. Und zwar so relevant, dass die Suchmaschine diese möglichst weit vorn in den Suchergebnissen platziert.

Relevanz schaffen: Keyword-Dichte und TF*IDF-Analyse

Helfen, Relevanz eines Artikel zu einem Keyowrd herzustellen,i können dabei die Keyword-Dichte und eine Termgewichtungs-Analyse (WDF*IDF / TF*IDF).

Bei einer Keyword-Dichte geht es darum, das Hauptkeyword im Verhältnis zum Gesamttext in einer Mindestanzahl zu erwähnen. Diese Technik gilt jedoch überholt.

Die Suchmaschinen sind intelligenter geworden. Reine Keyword-Wiederholungen bringen wenig und führen bei zu häufiger Anwendung zu einer Abstrafung in den Suchergebnissen.

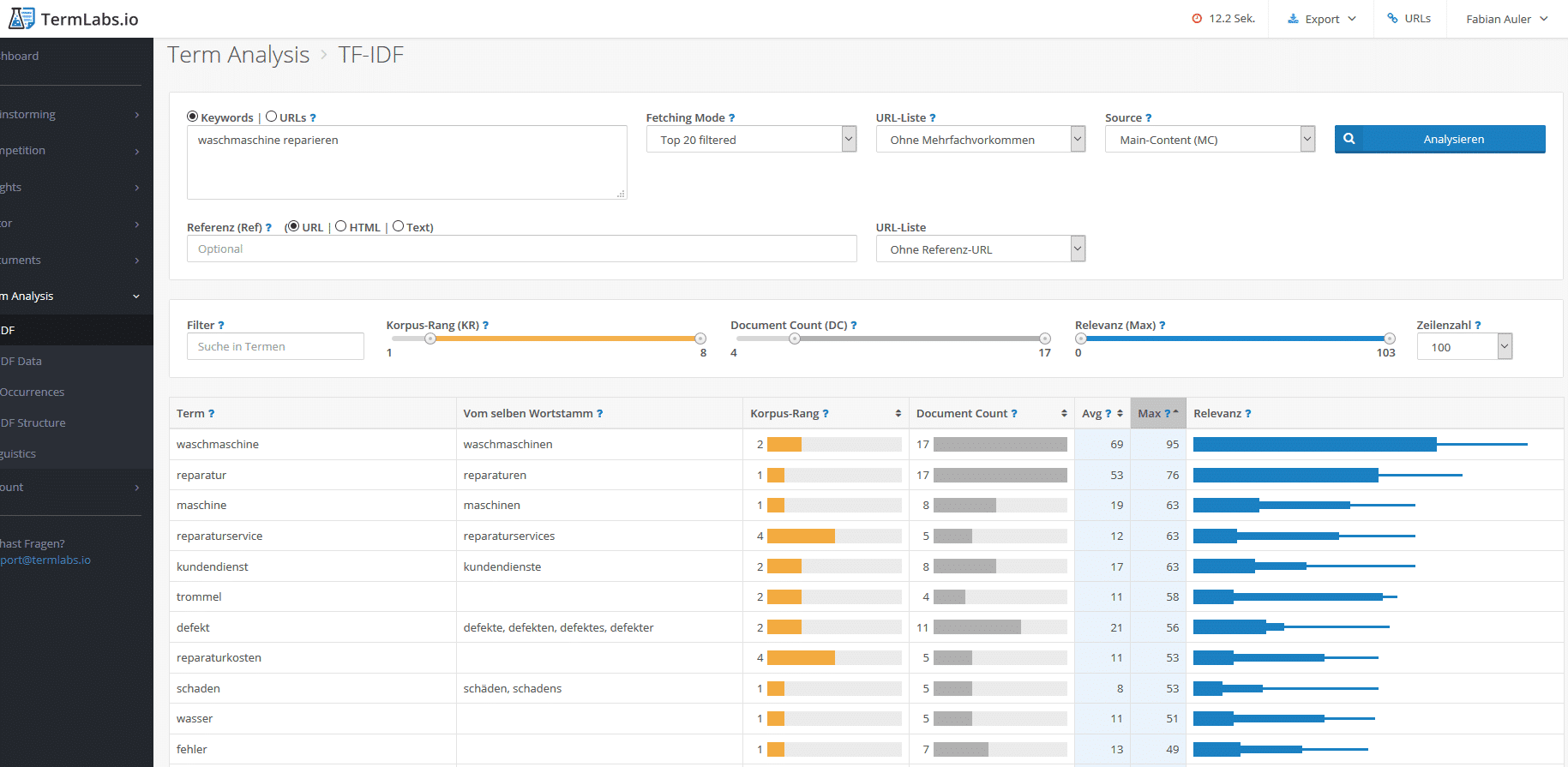

Mittels WDF*IDF wird angezeigt, wie häufig neben dem Keyword auch noch weitere Begriffe eingebaut werden sollten, um als relevant zu gelten. Bei der Analyse wird geprüft welche Begriffe wie oft verwendet werden und darauf eine Berechnung durchgeführt. Will man zum Beispiel zu “Waschmaschine reparieren” gut ranken, sollte man z. B. Begriffe wie „trommel“, „reparaturservice“, „pumpe“ verwenden.

TF*IDF wird von einigen SEOs kritisch gesehen: Mit hoher Wahrscheinlichkeit räumt Google Tf*IDF nur noch eine geringe Wertigkeit ein, da diese Wert zu leicht zu manipulieren sind.

Statt der besagten KEyword-Dichte und TF*IDF zu optimieren, sollte die Content-Optimierung ausschließlich auf den Nutzer ausgerichtet sein. Was ist die Suchintention des Nutzers, welche Probleme hat er und wie sieht die beste Lösung dazu aus?

Content-Design

Die Struktur des Textes ist wichtig: Die meisten Besucher scannen Texte und fangen erst dann an zu lesen. Eine reine Textwüste ohne Strukturen wird nicht gern gelesen und genau das kann negative Folgen für die Rankings haben. Daher muss der Text gut designt und strukturiert sein:

- Genügend Absätze, nach ca. 4–6 Zeilen kommt ein Absatz

- Mehrere Zwischenüberschriften, eine H1 pro Seite

- Bulletpoints, Aufzählungen

- Fettmarkierung von wichtigen Begriffen (nicht übertreiben)

- Definitionen und wichtige Aussagen optisch hervorheben

- Bilder, Videos, Tabellen und Grafiken und vieles mehr lockern das Lesen ebenfalls auf

Suchintention treffen

Damit Inhalte eine Chancen haben, gut gefunden zu werden und das zu liefern, wonach der Nutzer sucht, sollte die Suchintention für jedes Keyword berücksichtigt werden. Die Suchintention ist die „Suchabsicht“, mit der der Nutzer bei der Suchmaschine einen Begriff eingibt. Dabei wird nach verschiedenen Suchabsichten unterschieden:

- Transaktionsgetriebene Keywords: Diese können z. B. Suchbegriffe mit dem Zusatz „kaufen“, „bestellen“ oder „downloaden“ sein. Häufig können solche Suchanfragen auch kommerzielle Suchanfragen sein, besonders bei Begriffen wie „günstiger kaufen“ oder „online kaufen“.

- Informationsgetriebene Keywords: Hier sucht der Nutzer nach Antworten und Lösungen zu seinen Problemen. Sogenannte W-Fragen sind oft Informationsgetrieben, z. B. Was tun gegen Pickel?

- Brand Keywords: Hier gibt der Suchende den Namen der Firma oder die der Domain des Unternehmens ein.

- Navigationsgetriebene Keywords: Ähnlich wie bei Brand Keywords wird hier nur nach bestimmten Bereichen einer Domain gesucht, z. B. Zalando Kundenservice Telefonnummer. Die Domain ist bekannt, aber nicht die spezielle Unterseite.

Ein guter Hinweis, was zum jeweiligen Keyword gesucht wird, ist es (einfach, aber effektiv), sich die TOP 10 bei Google anzuschauen. Welche Ergebnisse spielt die Suchmaschine aus? Hier kann schnell die Suchintention bestimmt werden und kannst die eigenen Inhalte angepasst werden.

Das Panda Update

Das Panda Update von Google (das erste Update erschien im Februar 2011) ist ein Updates was sich gegen Websites mit mit minderwertigen Inhalten richtet. Solche Websites sind z. B. solche, die nur sehr wenige Texte haben.

Es gibt hier keine Mindestanzahl an Worten. Als grober Richtwert kann ich dir eine Mindestzahl von 500 Wörtern pro URL an die Hand geben. Ein Text über Christoph Columbus sollte deutlich mehr Wörter haben. Eine langweilige Kontaktseite mit einem Kontaktformular benötigt keine 500 Wörter. Für Webmaster empfiehlt sich folgende Punkte bei der Texterstellung zu vermeiden:

- Thin content (zu wenig Inhalt/Text)

- Content ohne Mehrwert, Lösungen oder Unterhaltung für den Leser

- Inhaltlich komplett falsche Texte (keine Unwahrheiten verbreiten)

- Unlesbare, reine Textwüsten

- Zu viele Rechtschreib- und Grammatikfehler

- Keine Texte von anderen kopieren (siehe unten Duplicate-Content-Problematik)

Empfehlungen von Google

In einem Blogbeitrag auf dem Google Webmasterblog von Danny Sullivan am 01.08.2019 wird erläutert, welchen Anforderungen die Inhalte einhalten müssen, um als qualitativ hochwertige Inhalte angesehen zu werden (und damit bestmögliche Chancen auf gute Rankings haben):

- Der Inhalt muss originelle Informationen, Berichte, Forschungen oder Analysen haben

- Der Inhalt sollte eine substantielle, vollständige oder umfassende Beschreibung des Themas sein

- Der Inhalt bietet aufschlussreiche Analysen oder interessante Informationen, die nicht offensichtlich sind

- Wenn der Inhalt auf anderen Quellen basiert, muss vermieden werden, diese Quellen einfach zu kopieren oder umzuschreiben, und stattdessen ein erheblicher Mehrwert und Originalität erzielt werden

- Die Überschrift und der Seitentitel sollen eine beschreibende und hilfreiche Zusammenfassung des Inhalts liefern

- Die Überschrift und der Seitentitel sollten nicht übertrieben oder schockierend zu wirken (Stichwort: Clickbait) und den Nutzer in die Irre führen.

- Der Content muss so gut sein, dass andere freiwillig diesen Verlinken und/oder mit Ihren Freunden teilen und diesen weiterempfehlen.

- Der Inhalt muss so gut sein, dass dieser auch in Zeitschriften, Enzyklopädien oder in Büchern zu finden sein würde

Aber nicht nur der Content muss gut sein, es müssen klare Vertrauens-Signale, die für ausstehende darauf schließen, dass der Inhalt gut und ordentlich recherchiert ist und glaubhaft ist:

- Klare Quellenangaben, Belege über die Fachkenntnisse des Autors und Hintergrundinformationen über diesen (Autorenbox).

- Der Leser muss erkennen können, dass der Autor als Autorität auf seinem Gebiet anerkannt wird.

- Der Inhalt muss von einem Experten oder Enthusiasten stammen, der nachweislich sich mit dem Thema gut auskennt

- Der Inhalt muss frei von leicht überprüfbaren sachlichen Fehlern sein

- Der Leser muss so viel Vertrauen haben in den Autor, dass dieser auch bei Fragen, zu Geld oder zum Leben (Your Money Your Life = YOYL Websites) des Lesern gerne diesem Inhalt anvertrauen. Durch die Einführung des E-A-T Modells von Google zur besseren Einordnung von Vertrauenswürdigen Inhalten und Websites sind die aufgezählten Vertrauenssignale sehr wichtig.

Nicht nur vom Autor müssen Vertrauenssignale da sein, sondern der Content an sich muss gut präsentiert werden auf der Website, dazu gibt Google folgendes Empfehlungen:

- Der Inhalt muss frei von Rechtschreib- oder Stilfragen sein

- Der Inhalt muss gut produziert sein und dementsprechend ansprechend präsentiert werden auf der Website. Schlampige oder hastige Fehler deuten auf eine schlechte Qualität

- Wenn die Inhalte wirken als wären diese massenhaft von einer großen Anzahl von Autoren produziert worden und entsprechend wenig Zeit in die Qualität des Contents gesteckt worden

- Der Content muss schnell zu finden sein und ohne große Werbung überlagert werden oder anderen Störelementen.

- Der Content muss auf auch mobilen Geräte gut lesbar sein

Zum Abschluss liefert Google noch folgende Empfehlungen über vergleichende Fragen:

- Der Content muss im Vergleich zu anderen Seiten in den Suchergebnissen einen erheblichen Mehrwert an Informationen liefern

- Der Text darf nicht den Eindruck erwecken, dass hier eine Überoptimierung stattgefunden hat, nur damit dieser bestmöglich in den Suchmaschinen gefunden wird. Der Content soll ausschließlich für den Leser geschrieben worden sein.

Bei der Optimierung von Texten ist es sinnvoll sich komplett auf die Besucher zu fokussieren und diese mit den Texten auf der Website einen echten Mehrwert, unterhaltung und Problemlösung anzubieten. Google ist zu schlau geworden und es ist nicht ratsam irgendwelche Tricks zu versuchen.

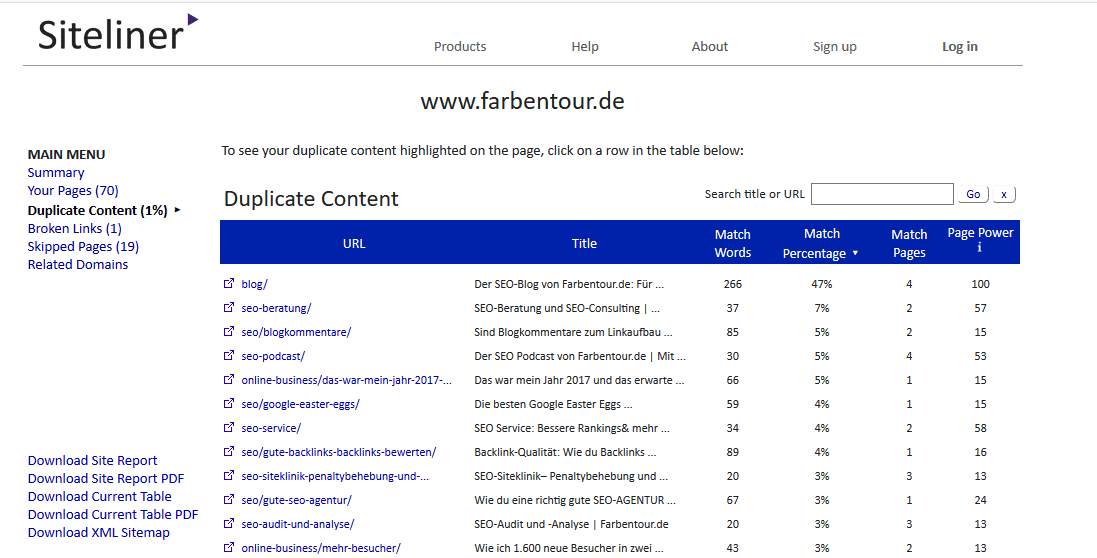

Duplicate Content

Es sollten keine Inhalte doppelt oder mehrfach auf verschiedenen URLs liegen haben. So etwas kann als Duplicate content betrachtet werden und kann unter Umständen Rankings gefährden. Daher sollte man keine Inhalte auf verschiedene URLS mehrfach veröffentlichten oder gar fremde Texte von anderen Quellen kopieren.

Das größte Problem ist hierbei für Google, zu erkennen, welche URL von den doppelten Inhalten relevant ist. Unter Umständen ranken dann keine von den URLS. Auch sind doppelte Inhalte ein Zeichen von schlecht gepflegten Websites, die ebenfalls nur wenig Vertrauen von Google erhalten.

Auf http://www.siteliner.com/ kann überprüft werden ob eine Website Duplciate Content Probleme hat.

Indexierungsmanagement

Die Häufigkeit und die Dauer des Crawling durch den Google-Bot ist limitiert. Das bedeutet, dass eine inhaltsarme Website mit vielen technischen Fehlern durchaus seltener gecrawlt wird als Websites, die sauber aufgebaut sind und einen hohen Nutzen für ihre Besucher haben.

Es sollten daher nur relevante Seiten indexierbar und alles technisch sauber sein:

– Inhaltsarme Seiten, wie z. B. „Wir wünschen unseren Kunden ein frohes neues Jahr 2016“ (oder älter) können gelöscht werden. Auch wenn der 10. Mitarbeiter eingestellt wird – einen Blogbeitrag mit 20 Wörtern daraus zu machen, sieht Google und die meisten Leser als nutzlos an. Faustregel: Alle Seiten, die laut Keyword-Recherche kein Suchvolumen aufweisen und damit keien Suchintention erfüllen, sollte überprüft werden, ob diese besser gelöscht werden.

– Seiten, die keine Suchintention haben, aber nicht gelöscht werden können, wie z. B. das Impressum, eine Kontaktseite usw., sollten auf noindex,follow gesetzt werden. Hier weiß Google dann sofort, dass solche Seiten nicht relevant für ihren Suchindex sind.

– Seiten mit Filter-Funktionen: Insbesondere Online-Shops haben oft Seiten mit unzähligen Filtervarianten und dadurch eine deutlich höhere Anzahl an URLs. Damit immer die richtigen URLs von Google indexiert werden, hilft das sogenannte Post-Redirect-Get-Pattern. Durch diese Methode können vom Google-Bot deutlich weniger URLs ausgelesen werden, als wenn Seiten über Canonical Tags oder Noindex,follow-Attribute markiert werden. Dies hilft bei großen Seiten mit besonders vielen URLs, die beispielsweise dynamisch generiert werden enorm, Crawler-Budget zu sparen.

– Broken Links – Seiten mit Links zu nicht mehr vorhandenen Seiten (egal ob intern oder extern) sollten behoben werden. Solche Fehler kann schnell ein sauberes Auslesen durch die Crawler erschweren.

– Alle URLs einer Website sollten einen sauberen Status-Code haben (200). Sonstige Status-Codes wie ein 404 Error (Seite nicht vorhanden) sollten vermieden werden..

– Interne Links können bei der OnPage-Optimierung sehr entscheidend sein. Verlinke wichtige Seiten, zu denen du gut gefunden werden willst, möglichst häufig und prominent auf der Website, z. B. im Menu, regelmäßig im Fließtext usw. Alles Weitere über Interne Links findest du hier auf dem SEO-Blog.

- Alles, was keine Suchintention hat und nicht gebraucht wird löschen!

- URLs, die nicht gelöscht werden können, wie Kontaktseite, Impressum, Datenschutz usw. auf noindex,follow setzen

- Interne Links: Broken Links stören Crawlbarkeit (ausgehende und interne)

- Crawlfehler prüfen und beheben über die Google Search Console

- Status Codes aller URLs sollte 200 sein (keine 4er, 5er)

- Interne Weiterleitungen und Weiterleitungsschleifen (Redirects) vermeiden

- Seitenebenenverteilung / Seitenarchitektur: Mit wie vielen Klicks erreichen Besucher eine bestimmte URL? Je wichtiger die URL, desto weniger Klicks sollten es sein

Verbotene Tricks:

Verbotene Techniken oder auch Black-Hat-SEO-Tricks bei der OnPage-Optimierung anzuwenden, sind mit einem enormen Risiko verbunden und sollten nicht mehr zum Einsatz kommen:

- Tricks, die früher funktioniert haben, wie das häufige / penetrante wiederholen von Keywords (Keyword-Spam), führen zu einem Google Penalty.

- Nutzer und Suchmaschine in die Irre führen, durch beispielsweise versteckte Inhalte (weiße Schrift auf weißem Hintergrund) sind ebenfalls zu vermeiden.

- Doorway Pages und sonstige Black Hat SEO Tricks, die den Suchmaschinen-Crawler austricksen wollen, sollte vermieden werden, da diese früher oder später erkannt werden von Google.

FAQ: Häufige Fragen zur OnPage Optimierung

Hier die Antworten zu häufige Fragen über die OnPage Optimierung.

Welches CMS (Content Management System) bevorzugt Google?

- Google bevorzugt kein bestimmtes CMS.

Java Script und SEO – kann das funktionieren?

- Den Suchmaschinen fällt es immer noch schwer, Java Script korrekt auszulesen. Ich kann Java-Script-Websites nicht empfehlen, falls mit so einer Website möglichst viel Traffic über Suchmaschinen erreicht werden soll.

Hat eine SSL / HTTPS Verschlüsselung Vorteile?

- Die Verschlüsselung einer Website durch ein Sicherheitszertifikat sendet ein zusätzliches Vertrauenssignal an Nutzer und Maschine. Seit es das kostenlose SSL Zertifikat „Let´s encrypt“ gibt, sollte kein Webmaster mehr darauf verzichten.

Ist Text/Code-Ratio ein Rankingfaktor?

- Die Text/Code-Ratio drückt aus, wieviel Text im Verhältnis zum Code (Seitenquelletext) auf einer Seite ist. Es gibt Quellen, die behaupten, eine zu große Anzahl an Code im Verhältnis zu Text sei ein negativer Rankingfaktor. Dies kann ich nicht bestätigten. Überlegt man, dass Video-Seiten und andere sehr Code-lastige Websites auch gute Rankings haben können, kann die Text/Code-Ratio vernachlässigt werden.

Was machen bei Website mit mehreren Sprachen?

- Gibt es verschiedene Sprachversionen auf deiner Website, musst du diese Sprache über die Attribute rel=“alternate“ hreflang=“x“ auszeichnen. Zusätzlich kannst du die Sprachversionen über die Search Console anmelden.

Subdomain VS. Verzeichnis – was ist sinnvoller?

- Ein Verzeichnis ist immer einer Subdomain vorzuziehen, da Subdomains wie eine eigenständige Website behandelt werden.

Zu viele Fehler im Seitenquelltext – ist das schlimm?

- Der Seitenquelltext sollte Fehlerfrei sein. Kleinere Fehler sind nicht schlimm, aber mehrere hundert Fehler können sich negativ auswirken.

Ist die mobile Darstellung wichtig?

- Wenn du keine optimierte Website für die mobilen Endgeräte hast, ist der Zug an dir seit Jahren schon vorbeigerast… In Zeiten von Mobile first sollten Websites heutzutage auf die mobilen Endgeräte wie Handys oder Tablets optimiert sein! Immer mehr User gehen über solche Geräte ins Internet und sitzen weniger vor dem Desktop-PC. Google hat durch Einführung des mobil first index klar gezeigt, dass jede Website für mobile Gerät optimiert sein.

Quellen

- Sitemap erstellen und einreichen: https://support.google.com/webmasters/answer/183668?hl=de

- Warum TF*IDF nicht sinnvoll im SEO ist: https://www.seo-suedwest.de/5024-seo-darum-ist-tf-idf-kein-sinnvolles-optimierungskriterium.html

- Welche Inhalte Google haben will: https://webmasters.googleblog.com/2019/08/core-updates.html

- Panda Update erklärt: https://www.searchenginejournal.com/google-algorithm-history/panda-update/

- PRG Pattern erklärt:https://de.ryte.com/wiki/Post-Redirect-Get

- Google bevorzugt kein bestimmtes CMS: https://www.seo-suedwest.de/3371-google-keine-bevorzugung-bestimmter-content-management-systeme-geplant.html

- Java Script und SEO Guide: https://www.onely.com/blog/ultimate-guide-javascript-seo/

- Subdomain vs Verzeichnis – Was ist besser? https://www.sistrix.de/news/subdomains-oder-unterverzeichnisse/

- HTML validieren und auf Fehler überprüfen: https://validator.w3.org/

- Google stellt vollständig auf Mobile First-Indexierung um: https://www.sistrix.de/news/google-stellt-vollstaendig-auf-mobile-first-indexierung-um/